Il mammifero rassicurante | On leadership as reassurance (Italian essay)

L’illusione dell’umano al centro e il lavoro invisibile che l’AI sta assorbendo

Note for English readers: This week’s essay explores a pattern I see often in organisations: leadership reduced to emotional reassurance. I’m publishing it first in Italian, where the concept is sharper. An English version will come later.

C’è un dato che circola nelle organizzazioni senza essere mai nominato apertamente: i modelli di AI generativa, in particolare i grandi modelli linguistici, funzionano meglio quando non devono decidere nulla. Funzionano quando non sono chiamati a chiudere, a scegliere, a produrre un esito irreversibile. Funzionano quando devono restare. Quando devono rispondere. Quando devono assorbire. Non è una provocazione ma un fatto osservabile nel modo in cui vengono usati, al di là del modo in cui vengono raccontati.

Le stesse aziende che li sviluppano lo mostrano nei dati. Nei report di utilizzo di OpenAI una parte rilevante delle interazioni non è orientata al compito: non c’è una domanda ben formulata, non c’è un output verificabile, non c’è una fine. Anthropic descrive molte conversazioni come exploratory: dialoghi che non cercano una risposta ma una continuità. Google DeepMind osserva dinamiche simili nell’uso di Gemini in ambienti di lavoro cognitivo, parlando apertamente di emotional reliance patterns: l’LLM non viene consultato per risolvere un compito ma mantenuto come riferimento continuo durante fasi di incertezza. Non è attivato per produrre un output ma tenuto aperto per regolare il carico cognitivo ed emotivo del lavoro.

Quello che ricorre è l’uso dell’AI non come strumento operativo ma come presenza conversazionale stabile. Non accelera un processo, non ottimizza una pipeline, non sblocca una decisione. Tiene compagnia alla decisione mentre non viene presa. Riempie il tempo tra un’ipotesi e l’altra. Offre una forma linguistica a pensieri ancora incompleti. In contesti dove l’incertezza è permanente, questa funzione vale più di qualsiasi promessa di efficienza.

Per capire cosa stia accadendo conviene spostare il linguaggio. “Produttività” descrive sempre meno il lavoro reale. Presuppone compiti definiti, obiettivi chiari, output misurabili. Ma una parte crescente del lavoro cognitivo e manageriale è lavoro nella nebbia: attendere che una variabile esterna si chiarisca, tenere insieme persone che non sono d’accordo ma non possono permettersi di esserlo apertamente, dare nomi provvisori a stati emotivi non ancora stabilizzati. In questa zona, il problema non è fare più in fretta. È non interrompere.

I modelli linguistici non eccellono nell’analisi fredda più degli umani: hanno bisogno di problemi ben posti, di vincoli espliciti, di istruzioni chiare. Dove la richiesta è deterministica, il loro vantaggio è limitato. Ma il confronto non avviene lì, avviene nel lavoro informale, non rendicontato, che non entra nei sistemi di valutazione ma tiene in piedi le organizzazioni: il bisogno di sentirsi ascoltati, legittimati, meno esposti mentre si attraversa l’ambiguità.

È qui che l’LLM trova la sua collocazione reale. Non come esperto ma come interlocutore che non forza una conclusione. Risponde sempre. Non prende posizione. Non introduce urgenza. Non crea conseguenze. Restituisce una forma linguistica anche quando il contenuto non è ancora chiaro. È un sistema statistico che viene vissuto come presenza affidabile proprio perché non chiede nulla in cambio.

I dati di utilizzo lo confermano. Le conversazioni si allungano quando non c’è un obiettivo chiaro, quando la domanda è confusa, quando l’utente non sa cosa chiedere. OpenAI registra una crescita delle interazioni orientate al thinking through: non “dimmi cosa fare”, ma “stai qui mentre ci penso”. Anthropic osserva ritorni sugli stessi thread non per arrivare a una soluzione, ma per mantenere un contesto stabile. Google nota che le sessioni più lunghe coincidono con i momenti di maggiore incertezza, non con i task più complessi. Il sistema non spinge verso una chiusura. Contiene. E così facendo riduce l’attrito emotivo che accompagna il lavoro sotto pressione.

Il punto cieco non è tecnologico. È organizzativo.

Per anni il lavoro umano, soprattutto nei livelli di coordinamento e leadership diffusa, ha incorporato una grande quantità di funzione emotiva senza poterla nominare. Riunioni che non servono a decidere ma a rassicurare. Feedback che non cambiano il corso delle cose ma mantengono l’impressione di controllo. Allineamenti, check-in, rituali linguistici ripetitivi. Tutto questo è lavoro, anche se raramente viene riconosciuto come tale. È un lavoro faticoso perché espone, consuma attenzione, produce debito simbolico.

Quando questa funzione viene svolta da un sistema conversazionale, la differenza non sta nella qualità della comprensione ma nell’assenza di rischio. Parlare con un LLM non comporta esposizione reputazionale, non crea asimmetrie visibili, non genera obblighi futuri. È una relazione senza memoria sociale, senza conseguenze. Proprio per questo è sostenibile.

È a questo punto che prende forma una narrazione rassicurante: l’umano resta al centro, l’AI assiste. Una storia ordinata, intuitiva, che conserva le gerarchie simboliche anche mentre il funzionamento reale dei sistemi cambia. L’umano decide, l’AI suggerisce. L’umano guida, l’AI supporta. Una divisione dei ruoli che tranquillizza perché lascia intatta l’idea di controllo, anche quando il controllo è già distribuito altrove.

Questa narrazione non descrive ciò che accade, lo rende accettabile. Sposta l’attenzione dall’organizzazione del lavoro alla postura individuale: basta usare bene lo strumento, restare vigili, ricordarsi che la responsabilità è nostra. Il cambiamento strutturale viene così tradotto in una questione di atteggiamento personale.

L’idea dell’AI come assistente funziona perché richiama una relazione già nota e socialmente legittima. L’assistente aiuta senza ridefinire il lavoro, rafforza la centralità di chi lo utilizza. Ma ciò che sta accadendo con i modelli linguistici non segue questo schema. Non perché l’AI diventi autonoma, ma perché occupa spazi che prima erano tenuti insieme da pratiche umane non dichiarate. Non prende decisioni, ma riorganizza il terreno su cui le decisioni maturano.

Dire che l’umano resta al centro implica che esista ancora un centro. Ma il lavoro cognitivo contemporaneo è già frammentato, distribuito, continuamente negoziato. L’LLM non sposta un baricentro stabile: entra in un sistema che quel baricentro lo ha già perso e si colloca negli interstizi. La responsabilità formale resta umana, visibile, firmabile. Il lavoro quotidiano di articolazione, chiarificazione, accompagnamento viene mediato altrove.

In questo senso l’AI non assiste l’umano: lo ricolloca. Non lo sostituisce, ma separa sempre di più il punto della responsabilità dal luogo in cui il lavoro prende forma. La narrazione dell’umano al centro serve a mantenere l’idea che queste due cose coincidano ancora.

Non c’è cinismo in questo. Né emancipazione. È un riassetto funzionale.

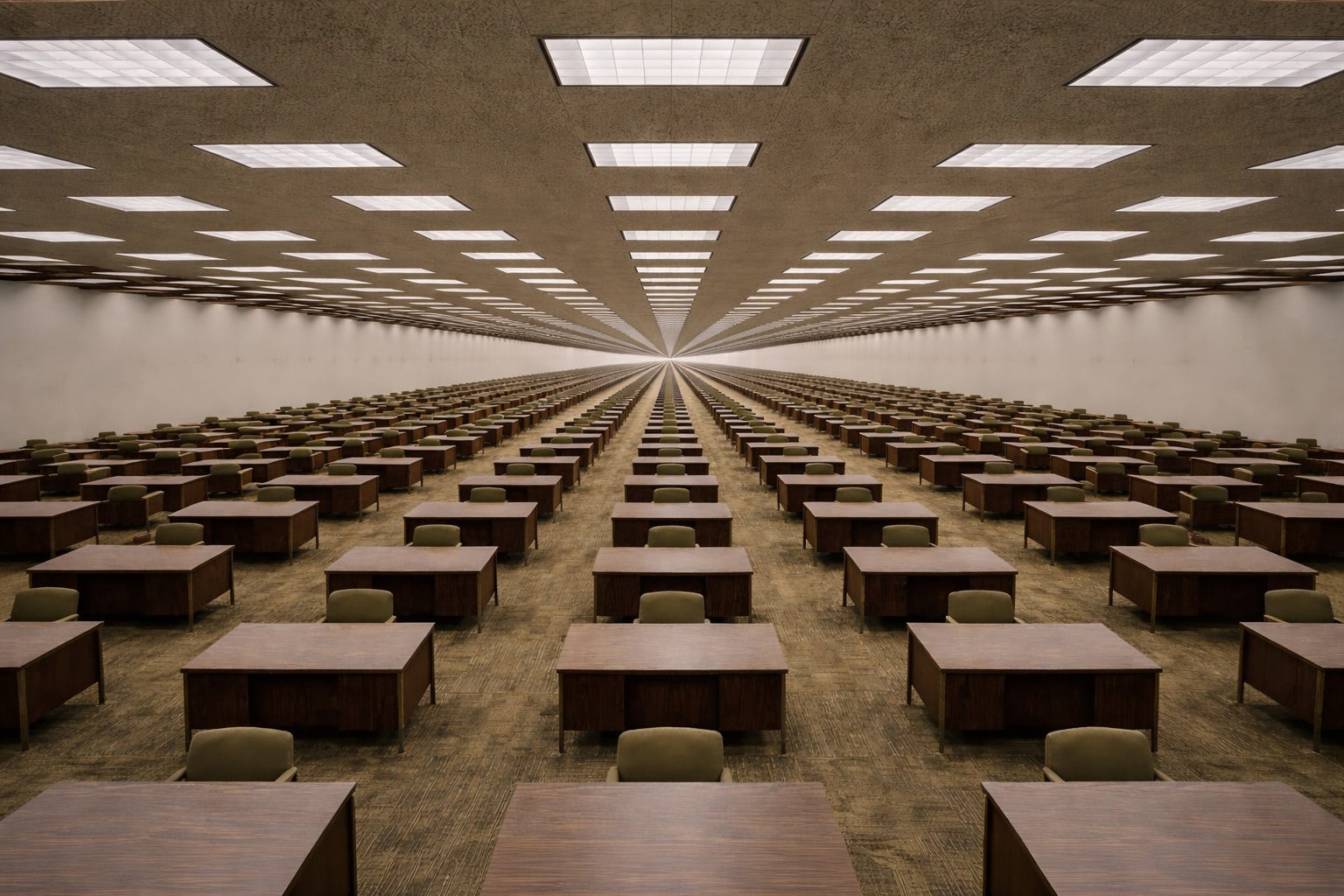

Il risultato è uno stato finale riconoscibile: organizzazioni in cui la relazione più stabile non è più tra persone ma tra individui e sistemi linguistici. Una relazione senza memoria, senza futuro, senza rischio. Funziona. Proprio per questo non viene messa in discussione.

Human & Machine studies how judgement fails under complexity. This piece is part of that work.